Bueno en Fin, fueron como 10 preguntas de las cuales tuve bien como 6 bien.

miércoles, 15 de marzo de 2017

1 SEMESTRE_Sistemas operativos

Cuestionario de Sistemas Operativos

Bueno el profe nos hiso un examen con varias preguntas como que el kernel,

cuales son los sistemas operativos más importantes, Que tipos de tipos de

sistemas operativos hay, Linux es un sistemas operativo.

Bueno en Fin, fueron como 10 preguntas de las cuales tuve bien como 6 bien.

Bueno en Fin, fueron como 10 preguntas de las cuales tuve bien como 6 bien.

domingo, 12 de marzo de 2017

1 SEMESTRE_ Kernel,Linux

Que es el Kernel de Windows y la diferencia con el

Kernel de Linux.

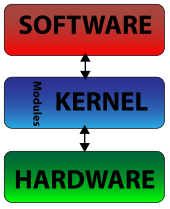

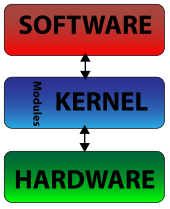

El Kernel de Windows es básicamente un componente fundamental de cualquier

sistema operativo, es el encargado de que el software y el hardware de cualquier

ordenador puedan trabajar juntos en un mismo sistema, para lo cual administra la

memoria de los programas y procesos ejecutados, el tiempo de procesador que

utilizan los programas, o se encarga de permitir el acceso y el correcto

funcionamiento de periféricos y otros elementos físicos del equipo.

Diferencia con el kernel de Linux

Bueno el kernel de Linux según la Información es similar al de Windows con unas

variaciones en el funcionamiento de este.

Administración de la memoria para todos los programas y procesos en

ejecución.

Administración del tiempo de procesador que los programas y procesos en

ejecución utilizan.

Es el encargado de que podamos acceder a los periféricos/elementos de

nuestro ordenador de una manera cómoda.

Bueno después que empezó a desarrollarse 2.6 del Kernel o núcleo existieron dos

versiones mas como son:

Versión de producción: La versión de producción, era la versión estable

hasta el momento. Esta versión era el resultado final de las versiones de

desarrollo o experimentales.

Versión de desarrollo: Esta versión era experimental y era la que

utilizaban los desarrolladores para programar, comprobar y verificar nuevas

características, correcciones, etc. Estos núcleos solían ser inestables y no

se debían usar sin saber lo que se hacía.

Cuando el equipo de desarrollo del núcleo experimental, decidía que tenía un

núcleo estable y con la suficiente calidad, se lanzaba una nueva versión de

producción o estable. Esta versión era la que se debía utilizar para un uso normal

del sistema, ya que eran las versiones consideradas más estables y libres de

fallos en el momento de su lanzamiento.

2

¿Para que Sirve? Ventajas y Desventajas

Kernel de Windows: Bueno sirve y se encarga de que tu software y tu hardware

funcionen conjuntamente, por ejemplo este se encarga de administrar la memoria,

los tiempos de procesamiento, al igual que administra la memoria de los

programas y procesos ejecutados, el tiempo de procesador que utilizan los

programas, o se encarga de permitir el acceso y el correcto funcionamiento de

periféricos y otros elementos físicos del equipo.

Kernel de Linux: El kernel Linux es el componente central de un sistema

operativo GNU/Linux. Un kernel se encarga de manejar los recursos hardware

como la CPU, la memoria y los discos duros, y proporciona abstracciones que le

dan a las aplicaciones una visión consistente de esos recursos.

Se encarga de interconectar todas las aplicaciones que se ejecutan en el “modo

usuario” hasta el hardware , y permitiendo a los procesos obtener información de

unos a otros utilizando la comunicación entre procesos (IPC).

Ventajas y Desventajas.

Kernel de Windows

° Es bastante modular, y está basado en dos capas principales, la del usuario y la

del Kernel.

° El Sistema ocupa cada una para diferentes cada tipo de sistema.

° Cuando accedes a una aplicación, esta accede al modo usuario, donde Windows

crea un proceso directo para la aplicación.

Kernel de Linux

° Es de Código abierto y cualquiera puede ingresar a él y modificarlo

personalmente.

° Linux cogieron los principios de modularidad de Unix y decidieron abrir el código

y las discusiones técnicas. Gracias a ello, Linux ha creado una comunidad

meritocratica de desarrolladores, una en la que todos pueden colaborar y en la

que cada cambio que se sugiere se debate con dureza para desechar las peores

ideas y quedarse con las mejores.

° Linux solo tiene una capa, o sea que es un núcleo monolítico.

3

Diferencias entre UEFI-BIOS

La BIOS es un tipo de firmware que localiza y prepara los componentes

electrónicos o periféricos de una PC, para comunicarlos con algún sistema

operativo que la gobernará. Para ello la máquina cargará ese sencillo programa en

la memoria RAM central del aparato. Características o Ventajas.

Puede ejecutar código para verificar la integridad de todos los

componentes del firmware antes de que se ejecute y lance el sistema

operativo.

Probar los componentes clave de hardware en la computadora para

garantizar que toda la información cargue correctamente y no genere

problemas sobre la información.

Controla módulos adicionales como la tarjeta de vídeo o la tarjeta de red

de área local, entre otros dispositivos.

Selecciona el dispositivo de arranque que puede ser el disco duro, una

unidad de CD o un dispositivo USB

La UEFI es una interfaz de firmware estándar para PCs, diseñada para reemplazar

el BIOS (sistema básico de entrada y salida). Es un estándar creado por más de

140 compañías tecnológicas que forman parte del consorcio UEFI, en el que se

incluye Microsoft. Se ha diseñado para mejorar la interoperabilidad del software y

solucionar las limitaciones del BIOS. Algunas de las ventajas que ofrece el

firmware UEFI son:

Ayudar a proteger el proceso previo al inicio frente a ataques de bootkit.

Tiempo de inicio y reanudación desde la hibernación más rápidos

Compatibilidad con unidades de disco duro con particiones de más de 2,2

terabytes (TB).

Compatibilidad con modernos controladores de dispositivos de firmware de

64 bits.

Capacidad para usar el BIOS con hardware UEFI.

Capacidad para usar Secure Boot.

4

Seguridad en BIOS y UEFI

Como la primera porción de código ejecutada por un dispositivo es alguno de

estos dos estándares, deben considerarse como un componente crítico para la

seguridad. De hecho, gestionar la seguridad en la BIOS permite fortalecer el

equipo desde el encendido. Dado que se ha detectado una posible vulnerabilidad

que afectaría el modo Secure Boot de la UEFI, es importante tener algunas

recomendaciones de seguridad que nos ayudan a elevar los niveles de seguridad

en nuestro equipo:

1. Todos los cambios a BIOS o UEFI deberán utilizar un mecanismo

autenticado de actualización o un mecanismo seguro de actualización

local.

2. El mecanismo de actualización local seguro sólo se debe usar

para cargar la primera imagen o para recuperarse de una corrupción en

el sistema de arranque.

3. También garantizará la autenticidad e integridad de la imagen de

actualización, especialmente si se trata de BIOS.

4. Para evitar la modificación no intencional o maliciosa del sistema, deberán

estar protegidos con un mecanismo que no se pueda reemplazar fuera

de una actualización autenticada.

5. El mecanismo de actualización será el único capaz de modificar el

BIOS del sistema sin necesidad de intervención física.

1 SEMESTRE_Diferencias entre Software. Firmware y Driver

Diferencias entre Software, Firmware y Driver.

Software: Son los programas informáticos que hacen posible la realización de

tareas específicas dentro de un computador. Por ejemplo Word, Excel, Power

Point, Navegadores web, Juegos, Los sistemas operativos etc.

Funciones de Software:

Administrar los recursos de computacionales

Proporcionar las herramientas para optimizar estos recursos.

Actuar como intermediario entre el usuario y la información almacenada.

Tipos de Software:

Software del sistema: Es un conjunto de programas que administran

los recursos de la computadora. Ejemplos: Unidad central de proceso,

dispositivos de comunicaciones y dispositivos periféricos, el software del

sistema administra y controla al acceso del hardware.

Software de aplicaciones: Programas que son escritos para o por los

usuarios para realizar una tarea especifica en la computadora. Ejemplo:

software para procesar un texto, para generar una hoja de calculo, el

software de aplicación debe estar sobre el software del sistema para

poder operar.

Software de usuario final: Es el software que permiten el desarrollo de

algunas aplicaciones directamente por los usuarios finales, el software

del usuario final con frecuencia tiene que trabajar a través del software

de aplicación y finalmente a través del software del sistema.

2

Firmware y Driver.

1. En ambos casos se trata de programas informáticos encargados de

comunicarse con el hardware (dispositivos electrónicos).

2. En el caso del firmware depende exclusivamente del hardware, el driver

depende del hardware y del sistema operativo. En el caso del driver, más

específicamente, se trata de un software que facilita que las aplicaciones del

sistema operativo interactúen con el hardware.

3. Como consecuencia del punto 2 el driver va instalado en el sistema operativo

(normalmente), mientras que el firmware acompaña al dispositivo, normalmente

en una Rom incluida en el mismo.

4. El firmware se puede actualizar a través del driver pero un fallo en la

actualización puede dejar el dispositivo inservible. El driver se puede actualizar

desde el sistema operativo sin problemas.

5. El firmware lo provee el fabricante del dispositivo, el driver puede que si,

puede que no ya que en el fondo les interesa que su dispositivo sea compatible

con cualquier sistema operativo; en el caso de Linux lo puede proveer

cualquiera y no porque sea más fácil hacerlo si no porque para Microsoft que

trabaje Gates.

6. El firmware siempre viene instalado en el dispositivo, el driver depende.

Microsoft incluye en su instalación la mayoría de los drivers de dispositivos del

mercado, y aparte cuando uno se compra un dispositivo suele traer un CD de

drivers para la mayoría de los sistemas operativos. En el caso de Linux, cada

vez son más compatibles los dispositivos pero suele dar un poquitín de dolor de

cabeza encontrarlos.

7. El firmware es raro tener que actualizarlo pero conviene revisar la página del

fabricante para posibles actualizaciones que hagan que funcione

correctamente, El fabricante nos indicará como verificar la versión instalada y

como realizar la nueva instalación. En el caso del driver suele haber más

actualizaciones y de la misma manera cuando uno se compra un dispositivo

conviene revisar el driver contra la página del fabricante.

3

• Bueno elo Software

a tenido

unaincreible

evolucion al paso

de los años ya que

este a evolucionado

en cuanto el

sistema y su

mejorabilidad para

poder usarlo.

Además, no existen

todavía

herramientas que

permitan estimar de

una manera exacta,

antes de comenzar

el proyecto, cuál es

el esfuerzo que se

necesitará para

desarrollar un

programa. Este

hecho provoca que

la mayoría de las

veces no sea

posible estimar

cuánto tiempo

llevará un proyecto,

ni

cuánto personal ser

á necesario.

Cuando se fijan

plazos normalmente

no se cumplen por

este hecho.

Software

Bueno la evolucion

de los Drivers.

Los autómatas

programables

aparecieron en los

Estados Unidos en

los años 1969-70, y

más particularmente

en el sector de la

industria del

automóvil; fueron

empleados en Europa

aproximadamente

dos años más tarde.

Su fecha de ceración

coincide, pues con el

comienzo de la era

del microprocesador

y con la generación

de la lógica cableada

modular.

1969

En 1969 la Bedfor

Associates propuso

algo denominado

Controlador Digital

Modular (MODICON,

Modular Digital

CONtroler) para la

División Hydramatic

de la General Motors,

la cual instaló el

primer PLC.

Driver

Evolucion del

Firmware.

El elemento que tenía

esta información en

los PCs hasta

mediados de los años

90, eran la ROM

(Read Only Memory)

y la BIOS (Basic

Input/Output System),

de los cuales ya

hable al describir

los Buses de Datos.

La ROM no podía

borrarse, lo cual era

conveniente para que

pasara lo que pasara

con en PC, siguiera

estando en su interior

el programa que

permitía trabajar a los

dispositivos del PC.

1 SEMESTRE_Yo en Internet.

Lo que Google sabe de Mí

Bueno en mi caso Google sabe algunas cosas de mí como por ejemplo sabe

los lugares en donde estuve, las rutas, así como mi número de teléfono, la

música y las búsquedas más recientes que he hecho en Google.

Bueno esto personalmente se me hace algo incómodo o más bien se podría

decir, que no me gusta la idea que tengan toda esa información los servicios de

Google. Aunque por otro lado si está bien porque por medio de esa información

las autoridades o la policía puede llegar a ver en caso de que necesite obtener

información de cada uno de nosotros. Bueno aunque la verdad también es

culpa de nosotros se podría decir las personas, pero en fin cada quien tiene

derecho a que vean o a ingresar sus Información o no.

Yo personalmente no sabía que Google recaudaba o tenía toda esa

Información acerca de nosotros y mucho menos los lugares en que he estado y

con qué personas he hablado.

También una cosa que se me hiso interesante es que Google también sabe

nuestra edad, genero al igual que una lista de las palabras más usadas a lo

largo de un Tiempo, también Google puede ver los correos que nosotros

hemos enviado y a quien se lo hemos enviado.

Bueno pero de igual modo si nosotros no queremos que la información siga

estando ahí hay la opción de borrarlo, aunque yo creo que toda esa

información que según nosotros borramos, sigue estando ahí en la cuentas de

Google o en la información de tu cuentas.

2

Conclusión

La verdad es que a veces no somos conscientes de lo que subimos a internet

como las redes sociales o los medios publicitarios, porque a partir de esa

información puede haber personas que la puedan llegar a utilizar con un fin

malo como sería un robo u otra cosa de mayor importancia o gravedad.

Pero como ya mencione también se podría usarcé para un fin bueno, como

puede ser para salvarnos la vida, por medio de esa Información.

Bueno concluyo que toda la responsabilidad cae sobre nosotros y que de igual

modo nosotros debemos de asumir la responsabilidad si llega a pasar algo con

esa información de nosotros, porque nosotros somos los que le damos todos

nuestros datos a Internet, así como también la de familiares o conocidos que

de igual modo pueden ser afectados.

De esta Práctica puedo llegar a decir que aprendí o conocí cosas que no me

imaginaba que Google pudiera hacer con cada uno de nosotros en cuanto a

nuestra Información, y ahora tendré más cuidado en lo que subo a Internet o a

mi cuenta de Google y sobre todo en las redes sociales, que es donde se

guarda gran parte de mi Información que yo pueda subir a los medios sociales.

1 SEMESTRE_Grace Hooper

Grace Hopper

Grace Brewster Murray Hopper, americana, Doctora en Matemáticas y

Almirante del Ejército Norteamericano (Nueva York, 1906 - Arlington, Virginia,

1992)

Grace Murray era descendiente de una familia americana de militares. En

1931, se casó con el profesor Vincent Foster Hopper. En 1934, fue nombrada

doctora en matemáticas por la famosa universidad de Yale. Enseñó allí

matemáticas desde 1931 a 1943, cuando la Marina Americana la solicitó para

colaborar en el "Cruft Laboratory" de la Universidad de Harvard en el marco de

un proyecto. La tarea de Hopper consistía en calcular los coeficientes

matemáticos del ordenador electromecánico llamado "Mark" . Muy rápidamente

dominó el ordenador en todos sus detalles. Durante su estancia la universidad

de Harvard, escribió un manual de 500 páginas sobre los principios

elementales del funcionamiento de una « máquina informática ».

Después de la Segunda Guerra Mundial, Grace Hopper trabajó para Eckert y

Mauchly, la empresa que concibió los primeros ordenadores comerciales.

Hopper estaba convencida de que los ordenadores podían llegar a un público

mucho más amplio si se creaban procedimientos más amistosos con la

finalidad de programación y de aplicaciones. Sabía se desmoronan mientras

que para implantar los ordenadores en las esferas no científicas, así como en

el sector comercial se debían afinar los lenguages para hacerlos comprensibles

por los no matemáticos. Su convicción de que los programas informáticos

podían ser escritos en inglés suscitaba continuamente la respuesta : « los

ordenadores no comprenden el inglés ».

Grace siguió su convicción y desarrolló en 1949 una técnica que traducía los

símbolos matemáticos a un código de instrucción binario y comprensible por la

máquina. Esta « técnica de traducción » no era otra más que el primer «

programa compilador » (A-O). Tres años más tarde, Grace y su equipo

sorprendieron al mundo informático presentando un programa de compilación

(B-O) que traducía las instrucciones de programación en inglés en un lenguaje

de programación Las bases de los lenguajes de programación modernos

fueron establecidas.

El compilador B-O (que se denominó posteriomente FLOW-MATIC) fue

concebido para el tratamiento de tareas típicas de la empresa tales como la

facturación y los pagos. Él provocó la apertura del ordenador en el mundo de la

empresa. FLOW-MATIC inspiró luego la creación del primer lenguaje de

programación orientado a la empresa (COBOL). Grace persuadió los dirigentes

de empresas y lde a Marina Norteamericana para utilizar COBOL como

lenguaje estándar.

2

Famosa por su trabajo en la Eckert-Mauchly

Computer Corporation, durante las décadas

de 1950 y 1960 se acreditó por el invento

del primer compilador (1952), un programa

que traduce las instrucciones con palabras en

inglés al lenguaje máquina de un ordenador.

Colaboró en el desarrollo del lenguaje de

programación Flow-Matic (1957) y el lenguaje

de programación COBOL (1959-1961),

orientado a los negocios para UNIVAC, la

primera computadora electrónica comercial.

Que fue lo que aporto Grace Hopper

* En 1950, Grace Hopper recibe el título de « programadora senior », una de

las 10 primeras personas que pueden gozar de este título. En una conferencia

que llegó a ser célebre, Grace Hopper predijo que el software acabará por

costar más caro que el material (hardware), lo que, en esa época, era

difícilmente imaginable.

* En 1969, fue la primera que recibió el premio del « Informático m/f del año ».

En 1971, una nueva recompensa anual dedicada a los jóvenes científicos en

informática m/f fue creada a su nombre ». * En 1983, fue promovida a

comandante en la "Casa Blanca", dos años más tarde, se la npmbró "Almirante

Grace Hopper" .

* En 1991, un año antes de su muerte, Grace Hopper recibió la "National Medal

of Technology" (1 " por los éxitos de sus trabajos pioneros en el desarrollo de

lenguajes de programación para ordenador que simplifican la tecnología

informática y abren la puerta a un universo de utilizadores significativamente

más amplio.

Finalmente Grace Hopper murió en el año de 1992 dejando un increíble legado

en la humanidad por que sin ella no existirían los sistemas operativos.

1 SEMESTRE_Diferencias Open Source,Software de Licencia libre y de autor

Diferencia entre open source-software libre-software de

licencia.

A pesar de que son términos relacionados y solemos usarlos

indistintamente, Software Libre y Open Source no son exactamente lo mismo, al

menos no según la FSF, de las iniciales de Free Software Foundation, organización

creada por Richard Stallman en el año 1985 con el propósito de difundir este

movimiento.

SOFTWARE LIBRE

El Software Libre o Free Software en inglés, es un software que respeta las

cuatro libertades que la FSF establece:

La libertad de usar el programa, con cualquier propósito.

La libertad de estudiar cómo funciona el programa y modificarlo,

adaptándolo a tus necesidades.

La libertad de distribuir copias del programa, con lo cual puedes ayudar a tu

prójimo.

La libertad de mejorar el programa y hacer públicas esas mejoras a los

demás, de modo que toda la comunidad se beneficie.

En otras palabras, es aquel que respeta la libertad de todos los usuarios que

adquirieron el producto para ser usado, copiado, estudiado, modificado, y

redistribuido libremente de varias formas. Es muy importante aclarar que el

Software Libre establece muchas libertades pero no es necesariamente gratuito.

Con esto quiero decir que conservando su carácter libre (respetando las

libertades), puede ser distribuido de manera comercial. Esto garantizando sus

derechos de modificación y redistribución.

2

Open Source

Open Source o código abierto, es la expresión con la que se conoce

al software distribuido y desarrollado libremente. Es un movimiento más

pragmático, se enfoca más en los beneficios prácticos como acceso al código

fuente que en aspectos éticos o de libertad que son tan relevantes en el Software

Libre.

Su premisa es que al compartir el código, el programa resultante tiende a ser

de calidad superior al software propietario, es una visión técnica. Obviamente

para lograr calidad técnica lo ideal es compartir el código, pero no estás obligado a

hacerlo.

Diferencias

Como podemos ver, el movimiento del Software Libre hace hincapié en cuestiones

éticas y morales relacionadas con el software, viendo el aspecto técnico como

secundario, a diferencia del movimiento Open Source que lo establece como

prioritario, siendo esta su diferencia más grande.

Otra de sus diferencias, quizá la más importante para lo que al ámbito comercial

concierne, es que con una aplicación desarrollada bajo los estándares del Software

Libre puedes obtener remuneración por conceptos de desarrollo, soporte y puesta a

punto siempre y cuando entregues los fuentes, a diferencia del movimiento Open

Source que no te obliga a hacerlo. Todos los productos desarrollados en Software

Libre así como sus derivados siempre deben ser libres, a diferencia de Open

Source.

Como podemos ver, básicamente el movimiento de Software Libre tiene diferencias de

índole filosóficas con el Open Source, sin embargo, ambos han permitido el desarrollo

de software de gran calidad y con muchísimas mas libertades de las que

el software privativo otorgaría jamás.

3

Software de Licencia

La licencia de software es, la autorización que el autor o autores, que son

quienes ostentan el derecho intelectual exclusivo de su obra, conceden a

otros para utilizar sus obras, en este caso los programas.

Los autores, pueden otorgar distinto tipo de licencia, pueden sólo autorizar su uso,

pueden autorizar su modificación o distribución, etc.

Vamos a ver los tipos de licencia de software más comunes que podemos

encontrar:

Freeware: Son Programas gratuitos, sin limites ni en el tiempo ni en la

funcionalidad del programa. En ocasiones podremos encontrarnos

programas que son freeware para uso personal, pero no podremos utilizar

en el ámbito comercial.

Shareware y Trial: El autor crea un software y lo distribuye a través de

diferentes medios, para que el usuario pueda evaluar de forma gratuita el

producto, normalmente por un tiempo especificado, aunque a veces el

programa limita las opciones. Una vez el periodo de prueba termina, bien se

abona el programa o bien se desinstala.

Estos programas los podemos utilizar de forma gratuita, normalmente por

un tiempo limitado. Una vez el periodo de prueba termina, tendremos que

comprar el programa o bien lo desinstalamos, porque el programa dejará de

funcionar.

Evaluación y Demo: Casi igual que el Shareware, pero en la mayoría de

los casos el periodo de prueba y las funcionalidades, suelen ser más

limitadas.

Adware: suelen ser programas shareware que de forma automática nos

muestra o nos descarga publicidad a nuestro PC, a veces sólo cuando lo

ejecutamos, otras simplemente cuando lo instalamos. Cuando compramos

la versión registrada o la licencia, normalmente se eliminan los anuncios.

Hay que estar atentos a la hora de instalarlos, pues a veces dan opción

para evitar la instalación de publicidad.

Software libre: aquí el autor deja libertad a los usuarios, por tanto, el

programa puede ser usado, copiado, estudiado, modificado y redistribuido

libremente. Pero eso no quiere decir que tenga que ser obligatoriamente

gratis, podemos encontrarnos programas bajo esta licencia que son de

pago, aunque suelen ser muy económicos.

4

Como nos Afecta

Bueno por lo que entendí, a nosotros los seres mortales nos puede beneficiar o

nos puede afectar, por ejemplo si estamos haciendo un trabajo en Word y

queremos o necesitamos información, podemos sacarla de internet, y en algunos

casos poder extraer información de alguna pagina creada por algún usuario para

nuestro beneficio.

Sin embargo si nosotros por ejemplo queremos copiar esa información lo

podremos hacer así. Siempre y cuando no los permita la licencia del autor.

También podemos modificar ya sea información, aplicaciones, programas etc., de

alguna persona que los allá creado,(podremos modificarlo a nuestro gusto) para

eso sirve el Software Libre.

Por ejemplo el Software de Licencia se podría decir que es la autorización que los

autores de dichas cosas o programas nos dan a nosotros los usuarios para poder

utilizar sus obras en este caso los programas.

Así mismo si los autores de dichos programas deciden que los usuarios no

podamos modificarlo o copiar información de sus obras ahí es donde entra la

Licencia de dicho autor, para que podamos entrar a dicho programa nos pedirá

que consultemos a el autor de este para poder conseguir autorización.

Por ejemplo es como Windows si nosotros los usuarios queremos borrar una

carpeta de el sistema de Windows talvez si lo logremos, pero ya si nos vamos mas

adentro de Windows como los archivos del programa u otras carpetas necesarias

para que Windows funciones nos va a mandar un mensaje la PC donde nos dirá

que consultemos al Autor o Creador de dicho programa para poder hacer esto.

1 SEMESTRE_Libros de Ofimatica

Autor: Efraín Melgarejo Molina

http://www.autoreseditores.com/libro/2802/efrain-melgarejomolina/ofimatica.html

Editorial: Edición del autor

Versión y Fecha: 1/2014 (versión#1)

Temas: Introducción a sistema Windows, como crear carpetas y

archivos, Combinación dibujos o textos, (Windows-Word-Power point)

Autor: Raya Cabrera José Luis-Raya Gonzales Laura-Miraut Andrés David

http://www.ra-ma.es/libros/APLICACIONES-OFIMATICAS-2-EDICION-CFGMGUIA-DEL-PROFESOR/84557/978-84-9964-243-7

Editorial. Ra-ma-Editorial

Versión y Fecha: 2013 (Version#1)

Temas: Modulo de aplicaciones ofimáticas, Programación didáctica,

Implantación de aplicaciones Ofimáticas, Técnicas de Soporte Ofimáticas

Autor: Erika Lorena Salinas

http://www.libreriavirgo.com.mx/libro/enfasis-de-campoofimatica-1-secundaria_134947

Editorial:

EDITORIAL UMBRAL S.A DE C.V.

Versión y Fecha: 2013 (Versión #1)

Temas: Windosw-word-sistemas operativos

2

Autor: Ana Martos Rubio

http://www.agapea.com/Ana-Martos-Rubio/Introduccion-a-la-Informatica-

9788441536104-i.htm

Edición y fecha: 2015 (Fecha 02/10/2014)

Temas: Programación en la Ofimática, Medios digitales y creatividad en el

sistema.

Autores: Erika Lorena Salinas Espinoza

http://www.libreriavirgo.com.mx/libro/enfasis-de-campo-ofimatica-3-

secundaria_134961

Editorial: Editorial Umbral S.A DE C.V

Fecha y edición: 2013 (Fecha 02/10/2014)

Temas: Manejar Word-Windows-Sistemas Operativos de la PC y Desarrollo en

la diferente Tecnología.

3

Autor: Francisca Montañés Muños

http://especiales.publico.es/libros/37938/ofimatica-yproceso-de-la-informacion-grado-superior

Editorial: McGraw-Hill Interamericana de España,

S.A.

Fecha y edicion: 1ª ed., 1ª imp (Fecha 2012)

Temas: CD del alumno: documentos y ejercicios de

trabajo, documentos y ejercicios de ampliación, páginas

Web, Glosario, bibliografía, presentaciones, unidad

Windows XP.

Autor: Josefina Jiménez Santos

http://edicionespuntofijo.com/catalogo/tecnologiacon-enfasis-en-ofimatica-1/

Editorial: Punto Fijo

Fecha y edición: Primera (2015)

Temas: Tecnologías de la Salud los servicios y la

recreación en cuanto a la Ofimática.

Autor: Gema María Valentín López

http://www.agapea.com/libros/Manual-OfimaticaCertificados-de-profesionalidad-9788468156828-

i.htm

Editorial: CEP, SL

Fecha y Edición: Edicion#1 (Fecha 19/02/2015)

Temas: Introducción a la Ofimática-WindowsProgramas

Electrónicos.

4

Autor: Josefina Jiménez Santos

Edición: Primera (2015)

Editorial: Punto Fijo

http://edicionespuntofijo.com/catalogo/tecnologia-con-enfasis-en-ofimatica-3/

Fecha: fecha de impresión 2011

Temas: Tecnologías de la salud en la Ofimática.

Servicios electrónicos en la Ofimática

1 SEMESTRE_Ensayo Ramanujan

Vida de Srinivasa Ramanujan

Bueno Srinivasa Ramanujan nacio el 22 de Diciembre de 1887 en casa de su

abuela en Erode(India) y murió el 26 de Abril de 1920 en Kumbakonam, donde

pasó la mayor parte de su vida, puesto que sus padres se trasladaron allí cuando

él tenía un año.

Fue por primera vez al colegio, al Town High School de Kumbakonam. Alli fue

donde encontró un libro de matemáticas de G.S.Carr, “Sinopsis elemental de

matemáticas pura”, que despertó su Interés por las matemáticas a cuyo estudio

dedico toda su vida.

Al finalizar la escuela secundaria recibió otra beca para la Universidad; sin

embargo, su pasión por las matemáticas le impidieron concentrarse en otras

asignaturas, hasta tal punto que tuvo que abandonarla.

En 1912, fue animado a comunicar sus increíbles resultados a varios

matemáticos de Inglaterra (La india en ese entonces era colonia británica).

M.J.M. Hill del University College de Londres comento que Ramanujan que

“tenia buen gusto por las matemáticas y capacidad”, pero que carecía de la

Formación necesaria para poder ser aceptado en el mundo matemático. A pesar

de ello, le dio algunos consejos para continuar con su trabajo. Por el contrario,

los catedráticos de la Universidad de Cambridge H.F. Baker y E.W. Hobson

devolvieron sus cartas sin ningún comentario.

Finalmente, y de autentica casualidad, fue Godfrey Harold Hardy el que leyó

con la atención suficiente sus escritos de Ramanujan. Al principio pensó que

podría tratarse de un fraude, pero mas tarde llego a afirmar de tales formulas

que “Forzoso es que fueran verdaderas, por que de no serlo, nadie habría

tenido la imaginación necesaria para descubrirlas”

Hardy invitó a Ramanujan a Inglaterra, y desde entonces el matemático indio

alternó su residencia entre ambos países hasta que murió de tuberculosis en

1920 a la temprana edad de 32 años. Para entonces ya había recopilado más

de 3900 fórmulas e identidades, escrito varios libros bajo el título de Cuadernos

de Ramanujan, publicado 21 artículos (5 de ellos con Hardy) y realizado

significativos avances en varios campos de la matemática.

2

Algunas veces Ramanujan fue sometido a presión por parte de Hardy, para

sacar su máximo potencial y según la película Hardy le exigía pruebas para

poder entender mejor a Ramanujan. Sin embargo un dia tuvieron una fuerte

discusión entre ellos dos donde Ramanujan le menciono que el tenia esposa y

que el no podía estar ahí sin tener algún resultado por parte de Hardy y los

miembros de allí.

Sin embargo días después se volvieron a encontrar y fue allí donde Hardy le

menciono que lo avían aceptado para publicar su obras según note en la

Película. Al siguiente día Ramanujan empezó a tener tos frecuente días tras día,

no fue hasta que un día la tos y el dolor en su cuerpo fue tan fuerte que tuvo que

ir al hospital. Para colmo Ramanujan estaba enfermo de Tuberculosis severa,

allí fue donde el callo en depresión por un lado por que no tenia contestaciones

de su esposa en India mediante cartas que el le enviaba, y por otro lado por la

enfermedad, no fue hasta que un día decidió o intento suicidarse en la pasada

de un tren. Donde de nuevo tuvieron que llevarlo al Hospital, y fue ahí donde le

avisaron a Hardy que Ramanujan estaba en el hospital, mando que le trajeran

un taxi para trasladarse hasta donde el estaba para verlo.

Según la Película, cuando Hardy llego al donde se encontraba R. el estaba

Inconsciente, no fue hasta el siguiente día que despertó y pudo hablar con el.

Ese mismo día Hardy le entrego una carta de su esposa, al igual que R. le

entrego las Pruebas a el. Finalmente R. se pudo recuperar, no por completo de

su enfermedad, y fue ahí donde Hardy volvió a hablar con los miembros del

University Collage para que volvieran a darle otra oportunidad a R.

Increíblemente los miembros de ahí, le dieron el permiso a Ramanujan para ser

un nuevo Integrante el plantel de Matemáticas. Fue ahí donde R. después de

ser admitido volvió a India un año para volver con su esposa y abuela, sin

embargo el le prometió a H. que volvería trascurrido ese tiempo, pero después

de ese periodo le enviaron una carta a Hardy mencionándole que Ramanujan

avía Fallecido, a causa de su dolorosa Enfermedad(Tuberculosis).

de 1920 en Kumbakonam, donde pasó la mayor parte de su vida, puesto que

sus padres se trasladaron allí cuando él ten

3

Obra de Srinivasa Ramanujan

A comienzos de la década de 1910, Ramanujan ya era una figura local reconocida

por la comunidad matemática india, a pesar de que no había completado su

formación universitaria. Esta última fue, al menos en parte, la causa de que los

intentos de sus colegas por presentarlo a los matemáticos británicos de la época

fueran ignorados. Excepto en un caso: en 1913 Godfrey Harold Hardy, de la

Universidad de Cambridge, recibió por correo nueve páginas de fórmulas que le

parecieron, en sus propias palabras, "casi imposibles de creer". Hardy decidió que

nadie tendría imaginación para pergeñar un fraude tan elaborado, así que

respondió a Ramanujan solicitándole más pruebas de su trabajo.

CUADERNOS CRÍPTICOS

Hay una peculiaridad del trabajo de Ramanujan que durante casi un siglo ha

dificultado a otros matemáticos la interpretación de sus ideas: nunca demostraba

sus teoremas. De hecho, apenas escribía una sola palabra en sus anotaciones.

"Aunque escribió unos 30 artículos, murió antes de publicar todos sus hallazgos;

nuestras únicas pistas de sus ideas están en sus tres cuadernos y en otros

papeles dispersos por distintos lugares" "Sus cuadernos y papeles son muy

difíciles de descifrar; cientos de páginas de fórmulas garabateadas. Incluso

cuando uno entiende una fórmula, parece como si hubiera mucho más que no se

entiende".

A lo largo de los años, los matemáticos han ido descifrando laboriosamente el

críptico trabajo de Ramanujan. En 1976 el estadounidense George Andrews, de la

Universidad Estatal de Pensilvania, encontró un cuaderno perdido: el último que

Ramanujan escribió, ya en su lecho de muerte. No era realmente tal cuaderno,

sino 87 hojas sueltas y desordenadas que habían permanecido ignoradas entre

los fondos de la Biblioteca Wren del Trinity College de Cambridge. Las 600

fórmulas de estas páginas han dado mucho trabajo a los matemáticos durante

décadas. "Gran parte del trabajo de Bringmann, Ono, Zwegers y otros se deriva

del cuaderno perdido", señala Andrews.

4

Entre los hallazgos que continúan revelando los papeles de Ramanujan se

encuentra el último que Ono y su estudiante, Sarah Trebat-Leder, acaban de

desarrollar en un artículo que se publicará próximamente en la revista Research in

Number Theory.

El descubrimiento parte de la anécdota más conocida de Ramanujan. En 1918

Hardy acudió a visitar a su protegido, entonces enfermo de tuberculosis e

ingresado en un hospital cercano a Londres. Para animarle, Hardy le comentó que

había llegado hasta allí en un taxi con un número muy aburrido, el 1729. A lo que

Ramanujan, sentándose en la cama, replicó: "¡No, Hardy, es un número muy

interesante! Es el número más pequeño expresable como la suma de dos cubos

de dos diferentes maneras".

UN HALLAZGO VISIONARIO

En la Película, al final sale una escena donde Hardy toma un taxi con el numero

1729. A raíz de aquello se definieron los llamados números taxicab, cuya

propiedad es que pueden descomponerse como varias sumas distintas de dos

cubos positivos; en el caso de 1729, como la suma de los cubos de 1 y 12, o como

la suma de los cubos de 9 y 10. Al tratarse de dos sumas, el 1729 es el segundo

taxicab; el primero es 2, dos veces 1 al cubo. Más allá la cosa se complica: los

taxicab desde el tercero en adelante solo han podido calcularse con

superordenadores. Por ejemplo, el sexto es un número de 23 cifras, el

24153319581254312065344.

5

En 2013, durante un viaje a Inglaterra, Ono rebuscaba entre las hojas del

cuaderno perdido en Cambridge cuando divisó algo que le llamó la atención. En

una página aparecía su famoso 1729 descompuesto en sus sumas, pero había

algo más. "Mucho más", subraya Ono. "De hecho, la página incluía infinitos casi

aciertos del último Teorema de Fermat".

Este teorema, que no se demostró hasta 1994, expresa que la suma de los cubos

de dos números enteros positivos no puede ser otro cubo (lo mismo se aplica para

las potencias mayores de 3). La página revelaba que Ramanujan había llegado al

1729 como un caso particular de una ecuación de Euler que iguala las sumas de

dos cubos. Los "casi aciertos" son números que no llegan a refutar el teorema,

pero que se aproximan. Y con estas fórmulas, Ramanujan había planteado la

teoría de algo llamado superficie K3 que no se redescubriría hasta décadas

después.

"Las superficies K3 son generalizaciones de curvas elípticas, soluciones a

ecuaciones que se usan en criptografía y también en la famosa demostración del

último Teorema de Fermat por Andrew Wiles en los años 90", precisa Ono. El

matemático destaca que estas superficies se emplean hoy en la Teoría de

Cuerdas, un modelo de física cuántica. "En cierta manera, se puede decir que las

superficies K3 son tan importantes en la ciencia de hoy como el círculo lo fue hace

muchos siglos".

Ramanujan falleció de vuelta a su India natal en 1920, de tuberculosis o tal vez de

amebiasis hepática. Pero casi un siglo después de su desaparición, su trabajo aún

no ha dicho la última palabra. Andrews apunta que "el cuaderno perdido tendrá un

impacto duradero y seguirá estudiándose durante años". Por su parte, Berndt

concluye: "Hoy entendemos cómo mucho de lo que hizo Ramanujan encaja en las

matemáticas modernas. Pero aún no comprendemos el pensamiento de

Ramanujan"

1 SEMESTRE_repaso. y memoria.booteable

TEMAS VISTOS EN CLASE

Competencias

genéricas.

Son un sistema complejo

de

conocimientos,creencias

y acciones construidos a

partirdel dominio.

Línea del tiempo

(Historia de la

computación)

El historial de cada

invento que aportó a la

creación de una

computadoras actual.

Biografía de Alan

Turing (Ensayo)

Biografía de el hombre,

considerado el padre

de la Informática y uno

de los inicios de la

historia de la

computadora.

Instalación de

Windows 7

Serie de pasos para

la correcta

instalación de

Windows 7 y sus

requisitos.

Sistemas operativos

(Linux, Mac OS y

Windows)

Cuadro comparativo entre

estos sistemas operativos,

con sus ventajas y

características principales.

Los hackers que

conectan a los pueblos

olvidados. (Ensayo)

Resumen y reflexión de la

lectura, mas un problema

y su solución.

Problemas y soluciones.

Problemas comunes de

partes específicas de la

computadora, junto a sus

soluciones.

Windows, Lunix, Mac

OS y Unix (Todas las

actualizaciones)

Cuadro en el que se

muestran actualizaciones

de cada uno de los SO y

sus características.

Memoria USB booteable Un USB "booteable" es un Drive USB, el con al cual puedes arrancar diversas aplicaciones. Ya sea un sistema operativo completo o simplemente un checkeo de memorias RAM. Puedes crear una infinidad de USB booteables según cuales sean tus necesidades. La creación de un USB booteable se ha vuelto muy común. Desde hace ya varios años podemos llevar nuestro Sistema Operativo en el bolsillo o en nuestro llavero. Me refiero a llevar un USB con nuestro Sistema Operativo listo para instalarlo en cualquier PC. Qué necesitamos Un USB formateado. Una imagen ISO booteable del Sistema Operativo que queramos instalar. l programa UltraISO. (UltraISO es una de las mejores herramientas para trabajar con imágenes de disco en formato ISO, ya que permite editar el contenido de una imagen ISO, extrayendo archivos o insertando otros nuevos. Una BIOS que soporte arrancar desde USB (Aunque desde hace varios años, todas lo soportan). Empezaremos instalando UltraISO y conectando nuestra memoria USB. Una vez instalado, abrimos UltraISO y seleccionamos la imagen que queramos copiar en el USB. Clickamos en Autoarranque y seleccionamos Grabar imagen de disco. Al hacer el paso anterior nos aparecerá una ventana. Buscamos el apartado Unidad y seleccionamos la unidad donde está montada nuestra memoria USB y para finalizar pulsamos en Grabar. Ya tenemos nuestro USB booteable con el Sistema Operativo listo para instalar. Ya podemos llevar nuestro Sistema Operativo favorito en el bolsillo de nuestra chaqueta listo para instalarlo en la situación que menos te lo esperes.

En este caso descargaríamos el sistema operativo Ubuntu, es un sistema operativo basado en GNU/Linux y que se distribuye como software libre, el cual incluye su propio entorno de escritorio denominado Unity.

Memoria USB booteable Un USB "booteable" es un Drive USB, el con al cual puedes arrancar diversas aplicaciones. Ya sea un sistema operativo completo o simplemente un checkeo de memorias RAM. Puedes crear una infinidad de USB booteables según cuales sean tus necesidades. La creación de un USB booteable se ha vuelto muy común. Desde hace ya varios años podemos llevar nuestro Sistema Operativo en el bolsillo o en nuestro llavero. Me refiero a llevar un USB con nuestro Sistema Operativo listo para instalarlo en cualquier PC. Qué necesitamos Un USB formateado. Una imagen ISO booteable del Sistema Operativo que queramos instalar. l programa UltraISO. (UltraISO es una de las mejores herramientas para trabajar con imágenes de disco en formato ISO, ya que permite editar el contenido de una imagen ISO, extrayendo archivos o insertando otros nuevos. Una BIOS que soporte arrancar desde USB (Aunque desde hace varios años, todas lo soportan). Empezaremos instalando UltraISO y conectando nuestra memoria USB. Una vez instalado, abrimos UltraISO y seleccionamos la imagen que queramos copiar en el USB. Clickamos en Autoarranque y seleccionamos Grabar imagen de disco. Al hacer el paso anterior nos aparecerá una ventana. Buscamos el apartado Unidad y seleccionamos la unidad donde está montada nuestra memoria USB y para finalizar pulsamos en Grabar. Ya tenemos nuestro USB booteable con el Sistema Operativo listo para instalar. Ya podemos llevar nuestro Sistema Operativo favorito en el bolsillo de nuestra chaqueta listo para instalarlo en la situación que menos te lo esperes.

En este caso descargaríamos el sistema operativo Ubuntu, es un sistema operativo basado en GNU/Linux y que se distribuye como software libre, el cual incluye su propio entorno de escritorio denominado Unity.

1 SEMESTRE_Problemas. Soluciones

Fuente de Poder

Como ya se había dicho, una fuente de poder en la pc son dispositivos

primordiales para el funcionamiento de cualquier ordenador, ya que son las

encargadas de suministrar la electricidad necesaria para el funcionamiento del

equipo.

1- La CPU no enciende: Lo primero que se debemos hacer es revisar

electricidad en la toma de corriente. Solo desconectamos el cable de

corriente del CPU de toma y probamos con alguna lámpara o cargador.

Los cables de corriente rara vez fallan, pero revisa que este bien

conectado el cable al CPU ya que suelen salirse con frecuencia

provocando falsos contactos.

2- Mala instalación eléctrica: Puede que la fuente no reciba

correctamente la tensión a causa de algún problema en la instalación

eléctrica de nuestra casa u oficina o el enchufe donde conectamos el pc

está dañado o quemado. Podemos probar en otro enchufe a ver si se

soluciona el problema.

3- Recalentamiento de la fuente: Para mantener la temperatura de la

fuente en niveles operativos, cuenta con un sistema de refrigeración por

convicción forzada, a cargo de un ventilador eléctrico que permanece

activo en todo momento enfriando la circuitería. Una buena fuente de

alimentación no es cara y es fácil de instalar y nos evitará muchos

disgustos.

4- Esta seleccionado el Voltaje Correcto (110/ 220 V)?: Si has

remplazado la fuente de poder o movido la PC, siempre existe la

posibilidad. Hay un pequeño interruptor rojo usualmente ubicado a un

lado del conector del cable de corriente en la parte trasera del gabinete.

Si enciendes la fuente con el interruptor puesto en 220Volts y estas

utilizando 110Volts, el sistema debe trabajar correctamente cuando

corrijas el voltaje. Si en cambio tienes seleccionado 110v y lo conectas a

una toma de corriente de 220v, lo más probable si es que tienes suerte,

se queme un fusible de la fuente de poder, o se dañe la fuente o algún

otro componente.

5- La fuente de poder no funcionaEsto es uno de los problemas más

comunes. Usualmente sucede si un

fusible está quemado, solo hay que

cambiarlo. Se tiene que quitar toda la

carcasa y también el circuito impreso

(Con un destornillador) y usando un

soldador o un cautín, se desuelda el fusil

que está próximo a la entrada de alterna

y se suelda otro similar.

Tarjeta madre

La tarjeta madre es la tarjeta principal en la estructura interna del

computador donde se encuentran los circuitos electrónicos, el

procesador, las memorias, y las conexiones principales, en ella se

conectan todos los componentes del computador.

1- Descarga electroestática: Si quiere actualizar la placa base,

asegúrese de protegerse contra las descargas electroestáticas. Toque

el interior de la caja antes de extraer la placa o use una pulsera

antiestática, mantenga la nueva placa dentro del envoltorio antiestático

hasta que llegue el momento de instalarla y cójala siempre por los

bordes. No toque nunca las soldaduras de la parte inferior ni los chips

de la parte superior de la placa porque pueden conducir electricidad y

provocar descargas electroestáticas en determinados componentes de

la placa base o tarjeta madre.

2- Error en el suministro eléctrico: Esto suele pasar si llega mal la

corriente, o la caja de suministro esta fastidiada. La solución sería

testear todos los cable que van a la tarjeta madre o placa base, revisar

que la conexión AC de la fuente este bien, si esto no funciona la única

solución sería reparar la fuente o cambiarla por una nueva.

3- Error de memoria RAM: (Ya sea que la memoria RAM este mala o sea

por problemas de polvo.) Lo que debemos de hacer es revisar que la

memoria RAM este bien insertada en los slots de memoria, si con esto

el problema todavía sigue debemos de limpiar

los slots de memoria y las memorias. si nuestra

tarjeta madre tiene uno o más slots y tenemos

dos memorias, probar arrancar el sistema con

una y sin con esto la pc enciende con

normalidad quiere decir que la memoria que

quitamos es la que está mal. Sin más, hay que

comprar una nueva.

4- CPU inservible o quemado: La solución a este

problema sería comprar una nueva tarjeta

madre y tener en mente que la tarjeta madre es un componente

electrónico muy útil pero muy delicado.

5- Sobrecalentamiento del chip de puente norte: El chipset es el

conjunto de circuitos que nos encontramos sobre la placa base. Se

encarga de conectar los distintos elementos que se encuentran en el

interior del CPU. El primer paso es limpiar el área de enfriamiento.

Tarjeta de Audio/Video

Una tarjeta de audio y video es la que es encarga de proporcionar la interface

auditiva al usuario y la tarjeta de video cumple la función de proporcionar la

interface gráfica al usuario por medio del monitor o pantalla.

1- El equipo no reproduce video: Verifique el cable de alimentación de

AC (Cable A) y que el monitor este encendido. Trate de ubicar un cable

para monitor que usted sepa que esta bueno (Cable B). Si con el cable A

el monitor no enciende y con el cable B en monitor enciende, entonces

el Cable A probablemente esté abierto por dentro, en este caso

asegúrese con un multímetro y reemplaza el cable

2- Las imágenes del monitor no tienen todos los colores:

Verifique que los controladores de video del adaptador de video

estén bien instalados. Esto se hace viendo las propiedades del Sistema

desde Windows en la opción Administrador de Dispositivos de la

categoría Sistema del Panel de Control.

3- El monitor tiene mucho brillo y las letras borrosas: El problema se

debe al desajuste en el alto voltaje y foco del Flyback. Necesitas abrir el

monitor y veras en la parte posterior del mismo un dispositivo color

negro conun cable que llega al cinescopio en forma de chupón este

dispositivo es el fly back, en este localizados controles, uno es para el

brillo y el otro para el foco, para el ajuste requieres que el monitoreste

encendido con la señal de la PC.

4- No hay un controlador de sonido en mi PC: Normalmente es un problema

de drivers. Pasa en ocasiones al formatear un ordenador e instalar

Windows de cero. Debemos averiguar cuál es el nombre de nuestra

tarjeta de sonido (Entra en Panel de control > Sistema > Administrador

de dispositivos > Dispositivos de sonido, vídeo y juegos).

5- El sonido se escucha sólo por un auricular. Es un problema inocente.

Creemos que está el sonido estropeado porque se oye sólo por un lado,

pero en realidad es el balance. Hay controladores del balance en el

control de audio de Windows y en algunos altavoces.

Monitores

El monitor es el principal dispositivo de salida, que

muestra datos o información al usuario.

1- El monitor se enciende pero no aparece la imagen: Pueden ser

varias las pruebas que podemos hacer antes de reportar el problema

como una falla electrónica. En la mayoría de los casos, este problema es

generado por que se mueven físicamente los botones de ajuste de

contraste y de brillo. Otra posible causa es que se soltó o está flojo el

cable en el conector de la tarjeta de video.

2- La pantalla se apaga después de un rato de trabajo: En las nuevas

computadoras, el programa de ROM BIOS (Setup) presenta la

posibilidad de apagar el monitor con el fin de economizar el consumo de

energía. Para determinar si su equipo tiene activada esta opción, cuando

se apague el monitor, mueva el mouse o presione una tecla cualquiera;

la imagen debe regresar, si no ocurre, reporte el daño al personal

calificado.

3- La imagen en pantalla, oscila o se mueva: La alimentación de energía

es baja y esto genera una fluctuación en la imagen, otra cosa es que

puede que se encuentra flojo el conector del monitor en la tarjeta de

video. Esto también puede ocasionar que su imagen se observe girando

o que los colores se cambien. El sitio donde está ubicado el sistema de

cómputo está cerca de ventiladores, sistemas de aire acondicionado,

lámparas fluorescentes grandes entre otros. Estos elementos producen

campos magnéticos que afectan el funcionamiento de la pantalla. La

solución, en este caso, es cambiar el sitio de la pantalla hasta que la

imagen quede estable. El circuito al cual está

conectado el sistema de cómputo no es

independiente y en él están conectando temporal o

permanentemente elementos de alta inducción como

son soldadores, taladros, aspiradoras, brilladoras y

en general, máquinas con motores eléctricos. La

solución es crear un circuito eléctrico independiente

preferiblemente con un transformador de

aislamiento.

4- El monitor produce zumbidos o ruidos: Estos ruidos son naturales en

los monitores. Pero si el ruido es demasiado alto, esto puede ser un

problema si es que te distrae de tu trabajo, repara o cambia el monitor

5- Imagen distorsionada: Esto puede ser un signo de interferencia de otro

aparato electrónico. Campos magnéticos pueden distorsionar la imagen

en un monitor. Si el monitor es expuesto por largos periodos, las

magnetos pueden dañar el monitor permanentemente. Para solucionar

este problema, aleja el monitor de lo que este causando la interferencia.

Memoria RAM

RAM son las siglas de random access memory, un tipo de memoria de

ordenador a la que se puede acceder aleatoriamente; es decir, se puede

acceder a cualquier byte de memoria sin acceder a los bytes precedentes. La

memoria RAM es el tipo de memoria más común en ordenadores y otros

dispositivos como impresoras.

1- Mensajes de error: Recibís mensajes de error que indican que no

tienes suficiente memoria. Este es el llamado de auxilio de tu

computadora, aunque probablemente el bajo rendimiento se note mucho

antes de que el equipo avise.

2- Pantallas azules: “La pantalla azul de la muerte" que con frecuencia

congela la computadora y requiere ser reiniciada. La "pantalla azul" es

una alerta del sistema que le informa sobre una falla en la memoria.

3- Monitor sin respuesta: El equipo se reinicia, pero no hay entrada del

video, por ejemplo la pantalla está negra a pesar de que las conexiones

están bien hechas.

4- Ruidos en el reinicio: La PC continúa pitando cuando se reinicia. Presta

atención a la cantidad de veces que pita porque es la forma cómo la

computadora te dice que hay un problema con la memoria.

5- No reinicia el sistema: La PC no se reinicia o bien se reinicia pero la PC se

rehúsa a cargar el sistema operativo, por ejemplo Windows.

Disco duro

Un disco duro es un elemento de almacenamiento de datos en forma magnética u

óptica, constituido por una lámina delgada con forma circular.

1- Se escucha un “Tap-Tap” rápido y seguido: El BIOS manda un

mensaje de error leyendo el driver C”. La causa, la sustancia magnética

que retiene los datos se está degradando. El problema podría

solucionarse, formateando el disco y si no es así el disco está dañado y

es necesario reemplazarlo.

2- El disco no gira y se calienta: Colocarlo debidamente los cables.

Una posible solución sería cambiar la planar del disco duro.

3- No carga el SO y realiza reinicios seguidos y aparece un mensaje

de error: No de los sectores de arranque del disco duro se ha dañado

el cual no permite completar el proceso para el inicio del sistema.

4- El disco no arranca: Primero se verifica que la fuente de poder aviente

los voltajes correctos al disco y de más componentes. De recibir voltajes

correctos se Verifica que el disco duro gire. Si no gira o hace ruidos

anormales debe ser falla mecánica. En este caso existen pocas

posibilidades de recuperación.

5- El circuito electrónico ha estado en corto porque huele a

quemado: Colocar correctamente los cables.

Tarjeta WLAN

Tambíen llamadas tarjetas Wi-Fi, son tarjetas para expansión de capacidades

que sirven para enviar y recibir datos sin la necesidad de cables en las redes

inalámbricas de área local.

1- Mi conexión de banda ancha se siente muy lenta al momento de bajar

archivos: Por desgracia, no hay mucho que puedas hacer para mejorar el

rendimiento de tu conexión de banda ancha sin gastar mas dinero para

mejorar tu servicio.

2- Se pierde la conexión al detectar otra: La primera cosa que debes de

hacer es abrir la página de propiedades de tu tarjeta Wi-Fi, ir a la pestaña

de Red inalámbrica, y dar un clic ha Avanzado. Deseleccionar “Conexión

automática a redes no preferidas”. Esto va a prevenir que tu maquina se

conecte automáticamente a redes vecinas.

3- El ancho de banda: Desconecta cualquier dispositivo que no estés usando.

4- No hay conexión de Internet: Lo mejor es desconectar el módem y

el router de la electricidad y esperar al menos 30 segundos antes de volver a

conectarlos.

5- Problema de hibernación de la tarjeta WiFi: En las propiedades de la

conexión de red (wifi), haga clic en la pestaña Opciones avanzadas, luego

desmarque la opción “autorizar al sistema a apagar este periférico”

Procesador.

Sistema Operativo.

Drivers(cualquiera que sea)

Teclado.

Puertos USB.

Cooler/Ventilador.

Procesador: Al terminar de leer el presente articulo, podrás conocer un

procedimiento adecuado para realizar un diagnostico acertado cuando tienes

problemas con el procesador, además aprenderás que síntomas podrían

presentar la PC si el procesador esta fallando y que hacer para solucionar el

problema.

Todos sabemos que el procesador es uno de las más importantes

componentes de la PC, ya que este es el cerebro de la computadora, y un mal

manejo del mismo podría ser fatal y afectar su normal funcionamiento.

Entre los principales síntomas que se presentan cuando el procesador esta

fallando se encuentran:

Al encender nuestra computadora, no tenemos señal de video en el

monitor, y ya hemos descartado las otras dos posibilidades: fallas en la

tarjeta madre o fallas en la tarjeta de video, entonces el problema puede

estar en el procesador.

En algunas ocasiones se inicia la computadora, carga el sistema de video y

se muestra la versión de la BIOS, se inicia la rutina POST, pero pueden

aparecer letras extrañas en la pantalla y las rutinas no se completan

adecuadamente, y el sistema deja de funcionar, este caso podría ser un

problema con el procesador, ya sea por fallas de fabrica o por

sobrecalentamiento y lo han dañado, en tal situación se deberá adquirir un

nuevo microprocesador

Sistema Operativo:

Primero. el sistema se pone lento:

Un sistema operativo pierde su eficacia, cuando tiene demasiados programas

instalados, un antivirus que puede ser bueno pero muy pesado, poca memoria

RAM, troyanos, demasiados archivos por lo general de audio y video, en

promedio y según mi experiencia el usuario poco experto es el más propenso a

sufrir de estos males, y el que más basura acumula en su sistema operativo,

pero no es nada que un usuario atento y dispuesto a dejarse enseñar, no

pueda aprender.

La solución es Asegurarte de que el técnico de confianza no solo haga el

arreglo, escucha sus recomendaciones, que te asesore, parte del soporte no es

solo arreglar el PC es también una oportunidad para el usuario de reforzar sus

conocimientos y de que le hagan caer en cuenta que puede estar haciendo

mal, visitando páginas nocivas para la PC, utilizando memorias desconocidas,

o en su defecto dejar el PC vulnerable y sin antivirus, para que no nos pase

esto debemos tener listo el antivirus y enumerar los programas que realmente

usamos, la compra de un computador siempre nos va ofrecer software que por

lo general no usaremos, y que por ende termina ocupando un espacio en la

máquina que mas bien debería ser aprovechado por otro programa que

si podría estar faltandonos en nuestros equipo de computo, es bueno solo tener

lo realmente necesario para no entorpecer el rendimiento y espacio que puede

darnos la maquina, muchos cometen el error de dejar que el técnico instale una

cantidad de programas que siempre terminan siendo basura para el usuario, no

se preocupen que yo también fui hace años atrás, un usuario promedio que

por el afán o la falta de conocimiento, permití que hicieran este tipo de

instalaciones, debído a esto mi pc se llenada de basura, de videos que no iba

ver, de musica que no era de mi gusto, esto nos ha pasado a la gran mayoría,

solo te numerare lo más común que debe tener en su pc un usuario Windows

sea Windows XP, Windows Vista, o Windows 7, aplica en todas las versiones:

Lo primero es familiarizarse con el Sistema Operativo si es Windows XP,

Windows Vista o Windows 7

Drivers:

Instalar nuevos programas o actualizar Windows, puede causar problemas en

programas. Un programa y un driver son dos cosas separadas.

Tú puedes actualizar un programa, mientras que el driver se queda en la

misma versión, o al revés. Y esto es una fuente de muchos problemas.

La ultima versión de un programa, está desarrollada para trabajar con la última

versión de drivers. Si los drivers de tu ordenador están actualizados, puede

causar estos conflictos y muchos problemas en los programas que utilizas.

También sucede que con el tiempo, los fabricantes de drivers publican nuevas

versiones de sus drivers en internet. Estas nuevas versiones solucionan

problemas y en muchas ocasiones son drivers con mayor rendimiento.

Un driver scanner tiene la capacidad de verificar si los drivers de tu ordenador

son viejos y verifica cada driver, para ver si hay una versión nueva o no.

Cuando el driver scanner detecta que hay una nueva versión, el driver scanner

baja automáticamente el driver y actualiza el driver viejo.

Teclado:

Ya no salen acentos, ni eñes. Está todo cambiado de sitio

2. Las teclas Control y Alt no funcionan, los atajos / combinaciones no

van

3. Las teclas especiales / multimedia no van

4. Una tecla no funciona, parece dañada / rota / atascada…

5. El ordenador escribe solo, las teclas se presionan, escribo pero no

ocurre nada…

Si estás escribiendo y de repente no te funcionan los acentos, no empieces a

gritar: lo más probable es que hayas pulsado sin querer los atajos de

teclado Alt+Mayús o Control+Mayús. Para volver a la normalidad, vuelve a

presionar el atajo correspondiente.

Los atajos de teclado (tecla especial+letra) son, como dice el nombre, métodos

abreviados para pedir a Windows que haga algo. Si dejan de funcionar, puede

deberse a muchos motivos, pero dos de los más frecuentes tienen que ver con

Teclas especiales (StickyKeys) y atajos conflictivos.

Teclas especiales o Sticky Keys es una función de accesibilidad de

Windows que se diseñó para facilitar el uso del teclado por parte de personas

que tienen dificultad en presionar dos teclas al mismo tiempo. Se invocan

pulsando las mayúsculas cinco veces seguidas y si se activan crean toda

una serie de problemas. Para desactivar las StickyKeys, sigue nuestro tutorial.

Las teclas multimedia son aquellas que permiten cambiar el volumen del

sonido, silenciarlo o cambiar de pista. Hoy en día, sólo los teclados básicos

carecen de ellas. Modelos más avanzados pueden incluir ruedas para navegar

por páginas, botones para abrir programas e pantallas LCD.

Si dejan de funcionar, la causa tiene que ver casi seguro con

los controladores (drivers) del teclado. Los teclados Microsoft y Logitech -las

dos marcas de periféricos más famosas- tienen sus propios paquetes de

controladores: IntelliType y SetPoint respectivamente. ¿El fabricante es otro?

Lee nuestra guía sobre controladores para encontrarlo.

Ya no se hacen teclados como los IBM Serie M, que eran engendros

mecánicos indestructibles. Los teclados de hoy en día son de membrana, y

aunque hayan mejorado mucho su calidad en los últimos años, están sujetos a

roturas y atascos a menudo irreparables. Si no puedes reemplazar el teclado

o llevarlo a un taller, he aquí unas soluciones:

Limpia el teclado con un cepillo y un espray de CO2

¿Es un teclado inalámbrico? Comprueba la conexión IR/Bluetooth

y cambia las baterías

Si eso no funciona, usa un teclado virtual mientras esperas para comprar un

reemplazo

En caso de emergencia, reasigna la tecla dañada a otra con

un “mapeador” de teclas

Tu teclado no está hechizado. Lo más probable es que tu PC esté infectado

con un virus o un programa espía. El malware suele interceptar las

pulsaciones de teclado para sustraer información sensible, como números de

tarjetas de crédito o contraseñas.

Puerto USB:

Es fundamental que los puertos USB estén perfectamente conectados a la

motherboard, para lo cual deberemos consultar de forma detenida el manual de

nuestra placa base para realizar una conexión correcta.

Tengamos en cuenta que un montaje erróneo del componente provocará fallas

importantes, que resultarán en un mal funcionamiento o bien en una avería

permanente del puerto y de los dispositivos que deseemos conectar a la PC por

intermedio del USB.

Cables 5v y Gr

Es de vital importancia que los cables 5v y Gr estén conectados en el lugar que

corresponde, porque de lo contrario estaríamos enviando 5 voltios al circuito que

se debe utilizar para el envío y recepción de datos. Esto provocará la rotura

permanente de alguno de los componentes de nuestra computadora.

Esta falla, que provoca quemaduras irreparables en el puerto USB y en los

circuitos de USB de la motherboard, también puede llegar a producirse cuando

conectamos a los puertos dispositivos cuyo conector USB se encuentra en mal estado o

en corto circuito.

Lamentablemente esta es una de las fallas más graves que pueden llegar a sufrir

los puertos USB, y que involucran de manera directa a nuestra placa madre, ya

que en este caso no es posible su reparación, por lo deberemos cambiar los

componentes.

No obstante, nuestra computadora puede estar trabajando con un problema de esta

índole sin que nos demos cuenta, ya que puede llegar a reportar que el puerto USB se

encuentra trabajando normalmente.

Para lograr saber si en verdad los puertos USB están bien conectados,

deberemos estar atentos a una serie de factores en el funcionamiento de los

mismos durante la conexión de dispositivos.

Ventilador:

Las averías más comunes son:

– Bloqueos del equipo: El equipo no obedece y se queda clavado en

Windows.

– Reinicios continuos: La placa detecta el sobrecalentamiento del micro y

reinicia el sistema.

– El equipo se apaga: La placa detecta el sobrecalentamiento del micro y

apaga el equipo al poco tiempo de estar encendido.

– Ventilador ruidoso: La placa detecta el sobrecalentamiento del micro y

acelera las revoluciones del ventilador para una mejor refrigeración

aumentando la contaminación acustica (db).

1- Para comenzar tendremos que abrir el equipo extrayendo una de sus tapas

laterales, en el cual localizamos el ventilador y procedemos a desconectar el

cable que lo alimenta:

2- Para extraer el ventilador junto con el disipador debe de aflojar con un

destornillador plano las 4 patillas siguiendo el sentido de las flechas que se

puede apreciar en la parte superior de las patas de anclaje:

3- Una vez giradas en sentido de las flechas haga presión hacia arriba en cada

una de ellas con el fin de que se liberen de la placa base.

4- Para poder limpiarlo con facilidad es mejor separar las aspas que sujetan el

ventilador al disipador, para ello, localice las pestañas de sujeción que se

pueden ver por los laterales y presione hacia afuera:

5- Para limpiar el polvo del disipador usaremos una brocha sacudiendo toda la

parte superior.

6- Para el ventilador se puede usar brocha para elminar el polvo y si tenemos a

mano algún liquido limpiador de contactos alargaremos un poquitin más su vida

y reduciremos su ruido.

7- En este caso hemos tenido una avería por problemas de sobrecalentamiento

asi que será mejor cambiar la pasta térmica. Limpia completamente la

superficie del procesador y disipador para que no quede resto alguno.

Que quede así de brillante:

La parte inferior del disipador también:

8- La pasta térmica se puede adquirir en cualquier tienda de informática, y es la

que va a realizar las funciones de conductor térmico para facilitar la absorción

del calor del micro por parte del disipador. Con poner tan solo un poco de pasta

térmica en el centro del Micro y del tamaño de un grano de arroz es suficiente.

Tenga en cuenta que poner mucha es casi igual como no poner.

Se debe no expandir la pasta por la parte superior del micro, si lo sitúas en el

centro cuando encajes de nuevo el disipador el sólo hará la función de

expandirla.

Nota: Ponga un poquito más del tamaño de un grano de arroz, si pones más

de lo adecuado es como si no pusieras nada.

Nota: No hace falta expandirla ya que al poner el disipador encima con la

presión se expandirá sola.

9- Una vez limpio y brillando procedemos a poner todo en su sitio, para

ello hay que volver a girar las patas pero esta vez en sentido contrario o a la

ubicación original o sentido original. Situe el ventilador de forma que pueda

encajar en los agujeros de la placa:

10- Una vez encajado presione hacia abajo hasta que quede acoplado.

1 SEMESTRE_Windows, Linux, Mac Os y Unix

Año 1985,

Windows 1

Windows 1.0 fue

un sistema

operativo gráfico

de 16 bits

desarrollado por

Microsoft y lanzado

el 20 de Junio de

1985, siendo uno

de los primeros

sistemas gráficos

diseñados. ...

Este producto se

remonta a 1981,

cuando Microsoft

inició un proyecto

llamado Interface

Manager.

Año 1987,

Windows 2

Permitía, por

primera vez, a las

ventanas de

aplicación

superponerse entre

sí; a diferencia de

su predecesor,

Windows 1.0 , el

cual podía mostrar

sólo las ventanas

en mosaico vertical

y horizontal.

Windows 2.0

también introdujo

más sofisticados

métodos

abreviados.

Antes de que

surgieran las primeras

distribuciones, un

usuario

de Linux debía ser

algo experto en Unix;

no solo debía conocer

qué bibliotecas y

ejecutables

necesitaba para

iniciar el sistema y

que funcionase, sino

también los detalles

importantes que se

requieren en la

instalación y

configuración de los

archivos en el

sistema.

Las distribuciones

Linux comenzaron a

surgir poco después

de que el núcleo

Linux fuera utilizado

por otros

programadores

además de los

creadores originales.

Existía mayor interés

en desarrollar

un sistema

operativo que en

desarrollar

aplicaciones,

interfaces para los

usuarios o un paquete

de

software conveniente.

Entre las

distribuciones más

antiguas se incluían:

Dos discos

denominados H J

Lu's «Boot-root»

con el núcleo y un

mínimo de

herramientas para

utilizar.

ElCheetah fue

lanzado el 24 de

marzo del 2001, y

aunque tuvo algunas

criticas negativas,

por tener algunas

fallas, tampoco fue

tan mal recibido

puesto que se

pensaba que para

ser la primera

versión no estaba

nada mal.

si

stema operativo a la

compañia debido a

su amigable

inimportancia de OS

El sistema operativo

actual de Mac ha

sido muy importante

en la historia de

Apple, ya que se ha

vuelto un emblema

para la compañia

debido a su

amigable interfaz y a

su limpio diseño.

ahora sabemos de la

importancia de OS

X, pero de alguna

manera el software

tuvo que llegar a

tener el prestigio que

tiene, es por eso que

aquí enlistamos las

diferentes versiones

de Mac OS X que ha

habido desde su

primer

lanzamiento.nzamien

to.

Windows Linux Mac Os Unix

En 1970, se habla

oficialmente del

sistema operativo

UNIX ejecutado en

una PDP-11/20. Se

incluía en él un

programa para dar

formato a textos

(runoff) y un editor

de texto. Tanto el

sistema operativo

como los

programas fueron

escritos en el

lenguaje

ensamblador de la

PDP-11/20.

El historial de

versiones del sistema

operativo Android se

inició con el

lanzamiento de

Android beta en

noviembre de 2007.

La primera versión

comercial (de prueba),

Android 1.0, fue

lanzada en

septiembre de 2008.

Android es un sistema

operativo

móvil desarrollado

por Google y la Open

Handset Alliance, y ha

visto un número

de actualizaciones a

su sistema operativo

base desde su

lanzamiento original.

Estas actualizaciones

típicamente

corrigen fallos de

programa han sido

desarrolladas.

1 SEMESTRE_Los Hackers que conectan pueblos Olvidados

Los hackers que conectan a los pueblos olvidados.

En México existen muchos pueblos olvidados, que no tiene conexión a Internet,

radiodifusoras o tan siquiera servicio de celular. Un conjuto de técnicos de

Telecomunicaciones Indígenas Comunitarias se adentran a un pueblo llamado

San Juan Yaeé. A lo que el pueblo respondió emocionado. Son pocos los que

se internan en los caminos angostos y más profundos de la sierra. Son

contados los que visitan las pequeñas comunidades zapotecas salpicadas

entre montañas y bosque.

La misión no es fácil, mucho menos cuando se tienen que cargar todos

esos fierros y herramientas. En la cima de ese cerro está la antena que

hoy se cambiará y que sostiene parte del equipo —creado con software y

hardware libre— con el que es posible que este pueblo tenga su propia

red de telefonía celular. Con los técnicos, en plena faena, están el

secretario municipal y los regidores de Educación, Hacienda y Salud;

fueron elegidos por usos y costumbres para ocupar esos puestos como

parte del tequio, trabajo comunitario que rige la vida social de estas

tierras.

San Juan Yaeé, comunidad de poco más de mil habitantes, fue una de

las primeras en sumarse a la Telefonía Celular Comunitaria, iniciativa

impulsada por Rhizomática y Redes por la Diversidad, Equidad y

Sustentabilidad, A. C., organizaciones que desde 2013 trabajan con

pequeñas localidades para que operen y administren su propia red de